Notation du MOOC Architecture de l’information

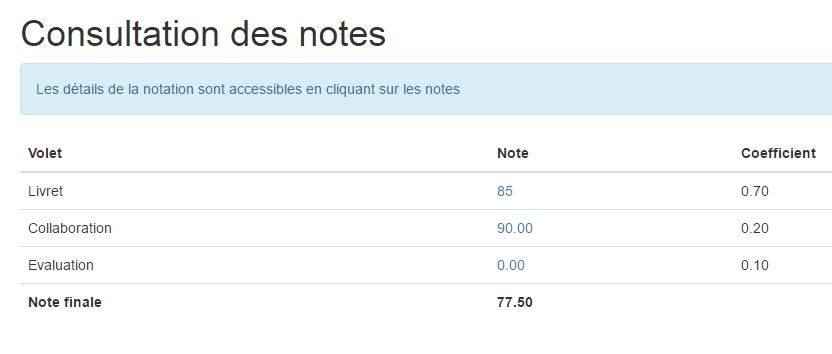

Je ne présente plus le MOOC ArchInfo, j’en ai déjà parlé. J’y reviens juste car les notes viennent de tomber. A partir d’un savant calcul, incluant l’ensemble des données de la cadence 2, décrit comme suit :

elle [la note] dépend principalement, bien sûr, de la qualité de votre livret, mesurée par les quatre évaluateurs (70%), mais aussi de celle des deux livrets que vous avez aidé à améliorer (20%) et enfin de l’écart entre la note que vous avez proposée aux livrets et celles proposées par vos pairs sur ces mêmes livrets (10%).

J’obtiens une note de 77,5 sur 100 (l’attestation de suivi de projet est donné à 50 pts). Cela m’interroge évidemment sur la notation : c’est toujours un beau sujet.

Déclinons les volets :

- Mon livret est noté 85, l’exacte moyenne des 4 notes données par les évaluateurs. Elles vont de 77 (qui met en commentaire un laconique “très bien”) à 95 avec une analyse très poussée (merci Julie qui m’avait donné la primeur de cette analyse). J’avais tenté la proposition d’un travail collaboratif pour rédiger une grille de correction sur le fil de discussion du MOOC : 4 intervenants. Chacun faisant comme il veut, l’écart de 18 points est normal.

- Sur l’aspect collaboration, la note est un peu tronquée, elle ne tient compte que d’un livret corrigé, celui de Paul-Henri Dumas. Si j’avais besoin d’une validation de plus pour savoir que je suis fait pour les systèmes de collaboration, la voila. Mais il faut surtout dire que son travail méritait cette note de 90 pts. L’autre livret n’a pas été rendu. Ce n’est pas un étonnement, je n’avais pas pu communiquer avec sa rédactrice.

- et sinon j’ai zéro en évaluation ! (Aïe, c’est pas un peu mon métier ça ?)

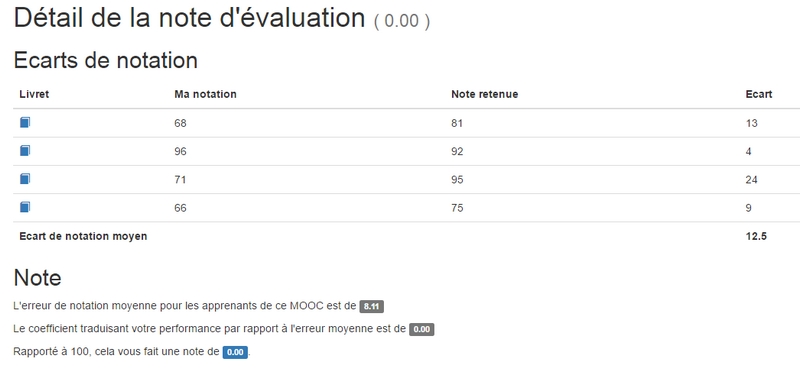

En fait, il valait mieux être un peu bisounours sur le MOOC ArchInfo et noter gentil. Le barème d’évaluation sur lequel j’ai basé ma grille de correction donnait ce qui suit :

Un barème sur 100 points peut être : 50 points pour les activités, 30 points pour les autres éléments, 10 points pour la forme, 10 points pour la personnalité. Ne passez pas trop de temps sur chaque livret à évaluer. L’objectif maintenant est de mettre une note et de la justifier.

Je suis relativement en phase avec les autres correcteurs sur 2 livrets (écarts de 4 et 9). Pour les deux autres et notamment un, j’explose le compteur. Sauf que ma suspicion naturelle s’étonne quand un livret (celui que j’ai noté 71) qui ne comporte pratiquement aucun autre élément que ceux demandés (-20 pts), avec une structure basique qui ne suit pas l’ordre des activités du MOOC (-5 pts), une orthographe limite et peu de personnalité (-4 pts), se retrouve avec une note retenue de 95.

Cela veut d’abord dire que des écarts importants étaient possibles. Sans grille de correction précise reprenant des critères communs, c’est assez normal.

Ensuite on peut se demander si les conditions ne permettaient pas une sur-évaluation des notes par certains apprenants. Le MOOC précisait des choses curieuses :

C’est pourquoi vous devez aussi anticiper les notes que pourraient donner les trois autres évaluateurs de chacun des livrets que vous notez et ne pas trop vous en éloigner.

Anticiper avec les données que l’on avait, c’était jouer aux devinettes. L’étape Collaboration juste avant créait une empathie pour les autres participants. Nous étions pile dans les conditions pour penser que les autres correcteurs allaient plutôt noter large.

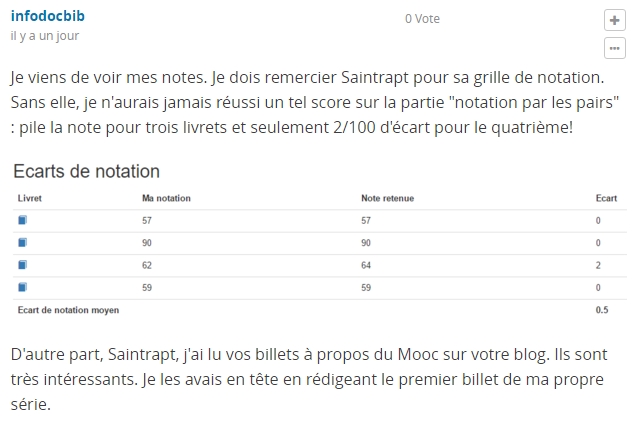

D’autres données pouvaient être prises en compte. Un des participants, infodocblb, le montrait bien sur le forum avec l’intervention suivante :

Je suis d’accord pour que tous ceux qui ont poursuivi jusqu’aux phases finales aient leur attestation. Mais la note est aussi prise en compte pour ceux qui veulent poursuivre par le DU “Conduite de projet en architecture de l’information“.

Noter en pensant au fait qu’on risque d’impacter sur l’avenir de jeunes (ou moins jeunes !) diplômés, quand on est pas concerné, c’est naturellement sur-évaluer.

Pour confirmer tout ça, je serais curieux de connaître l’écart maximal de notation d’un livret sur le MOOC (confirmant le besoin d’une grille de critères de notation plus précise), la moyenne des notes (pour confirmer ou infirmer une sur-évaluation) et enfin votre point de vue sur ce que vous venez de lire.

MàJ du 18.03.16

En plus des commentaires et réponses ci-dessous, copie d’un commentaire paru sur le forum du MOOC et d’un tweet qui pourraient réinterroger sur une grille de notation plus précise. Si l’argument de Jean-Michel Salaün sur les contestations d’interprétation de critères est évidemment valide, mon idée de construire une grille d’évaluation ensemble sur le MOOC pour que le plus grand nombre se l’approprie ensuite me paraît malgré tout toujours intéressante car de nature à vraiment engager les apprenants sur l’évaluation.

Intéressant puisque ce participant a eu la meilleure note aux livrets du MOOC ArchInfo : Voir son retour sur son site et son point de vue sur l’évaluation par les pairs tout aussi intéressant.

Bonjour Saintrapt,

La question de la notation dnas les MOOC est effectivement un sujet intéressant, mais je crois que votre avis est un peu biaisé par votre statut de formateur, alors que vous vous trouvez ici confronté à d’autres évaluateurs issus de milieux divers. Peut-être faut-il considérer aussi que votre notation était réellement trop sévère, plutôt que de présenter les autres évaluateurs comme des bisounours ?

Dans une notation par les pairs à grande échelle, il faut tenir compte de l’hétérogénéité des évaluateurs, des tactiques divergentes et de la différence de disponibilité (en temps et en intérêt) pour cet exercice. Je suis sceptique par expérience sur plusieurs de vos remarques.

Une grille de notation plus précise ne réduira pas les écarts entre les notes, mais risque de conduire à des contestations sur les interprétations, forcément différentes à cette échelle d’évaluateurs, des critères. De plus entrer dans trop de précisions amènera nombre d’évaluateurs à ne pas suivre la grille, faute de disponibilité ou d’intérêt. J’ai bien peur que son effet soit inverse. N’oubliez pas que seule une toute petite minorité s’exprime sur, et sans doute lit, le forum.

De même l’anticipation des notes qui vous a étonné est là pour réduire les tactiques individuelles et les connivences entre pairs. On en retrouve quelques unes malgré tout dans cette saison comme dans l’année précédente. Pour le coup, c’est moi qui vous trouve une peu bisounours. Rien ne dit que cette anticipation conduit à une surévaluation des notes. J’aurai plutôt l’hypothèse inverse. La facilité d’un raisonnement individuel rapide mène à la surnotation… sauf si on est incité à réviser son barème par rapport à celui d’autres évaluateurs.

Sur votre question sur les écarts, nous avons du intervenir sur une dizaine de notes de livret dont les écarts étaient supérieurs à 40%. Souvent suite à une erreur de l’évaluateur dans le remplissage du formulaire, parfois pour des raisons moins explicables. Nous ne sommes pas intervenu sur l’évaluation directe des livrets, nous avons simplement arbitré entre des évaluations trop divergentes.

Tout l’enjeu dans un MOOC est de se servir du nombre pour arriver à la notation la plus pertinente. C’est un raisonnement sensiblement différent de celui du formateur seul juge devant ses apprenants.

Merci de votre réaction ici.

J’ai dit ailleurs que je provoquais parfois pour obtenir une réaction, le mot “bisounours” était bien dans ce sens (et pas très sérieux au vu de la grande teneur du MOOC ArchInfo, j’en conviens !) mais s’il permet la discussion et donc d’établir une continuité, c’était pas si mal joué.

J’ai bien compris que mon analyse était limitée par ma posture de formateur, mais ce site est pour moi le moyen de réfléchir aux passerelles entre mes expériences en tant qu’apprenant et mes activités de formateur. Le fait de poser des questions “à haute voix” ici sur les outils, les méthodes, les évaluations et confronter mes pratiques à d’autres, notamment dans le champ de la formation à distance, c’est aussi me donner de nouvelles possibilités d’avancer.

Bonjour,

Assez d’accord avec vous sur l’évaluation des autres livrets. J’ai corrigé deux livrets (un incomplet et un illisible sur plusieurs parties à cause de la structure grammaticale et de l’orthographe). Ces livrets se sont retrouvés avec des notes meilleures que les 2 autres (complet et lisible).

Je reste donc perplexe sur cette note d’évaluation.

Bonjour Jean-Noël,

je suis l’apprenant du MOOC Archinfo auquel vous avez attribué la note de 71. Je vous avoue avoir été agréablement surpris par ma note de 95 pour le livret (je m’attendais à une note de ~80). Je ne sais vous dire si ma note a fait appel à un arbitrage, ce que je peux vous dire c’est qu’il y a consensus des trois autres évaluateurs (71/95/95/96) et qu’à priori la note médiane haute a été retenue conformément à la logique de notation qui a été publiée par l’ENS Lyon dans un esprit de transparence.

Notez que si les conditions étaient favorables à une sur-évaluation, comme vous vous le demandez, c’est aussi valable pour votre note.

J’ai personnellement attribué des notes de 75/80/65/70 en suivant le barème proposé par l’ENS et en arrondissant, pour au final un écart moyen de notation de 5 (respectivement 5/0/0/15). J’ai visiblement sous-évalué un livret en lui octroyant une note de 70 pour une note finale retenue de 85 (je ne serais donc pas touché par le syndrome du “Bisounours” ?). J’ai globalement essayé de suivre les consignes données par l’ENS pour noter, quand vous avez peut être voulu définir des critères de notation trop fins, au point près. Le mieux est l’ennemi du bien.

Il est évident que la notation par les pairs est un exercice difficile et subjectif. Qui a dit par exemple que les chapitres devaient suivre l’ordre des activités du MOOC ? L’ordre de mes chapitres est celui des six compétences de l’AI, tel que proposé par Jean-Michel Salaün dans la séquence “S1.2-Les compétences de l’AI” et qui nous invitait à ouvrir un chapitre pour chacune de ces six compétences. Ainsi, mes autres évaluateurs m’ont fait une remarque sur ce point mais sans le sanctionner.

Au vu de vos remarques (dans le billet ci-dessus) sur “l’orthographe un peu limite”, la “structure basique”, le “peu de personnalité”, de votre commentaire de notation qui fait état de votre “impression de vite-fait” et d’une “réalisation [des activités] un peu abrupte (manque de démarche)”, et en comparaison des commentaires très flatteurs de mes trois autres évaluateurs (que je ne connais pas, pour répondre à votre suspicion naturelle) qui, je cite, évoquent “Un livret extrêmement agréable à lire du début à la fin, fluide et complet. Les illustrations sont percutantes…”, “In overall it’s a great job, very well organized and I think it met all the requirements and more”, “Le livret est très bien présenté … Beaucoup de précision dans le travail … De loin le meilleur livret consulté.”, j’en viens à me demander si vous avez bien lu le même livret ?

Peut-être avez-vous sous-estimé le puissant effet apaisant que provoque l’esprit de synthèse sur le lecteur.

Je vous souhaite réussite dans vos projets.

Bien cordialement,

Laurent

Aïe pas taper 😉 Qui m’a dénoncé ? Ce n’était pas anonyme cette correction ?

Bon vous êtes là, tant mieux.

Réglons le souci de ma notation surévaluée : C’est à partir de ça que j’ai construit ma réflexion, ensuite viennent les autres. Je suis d’accord avec vous, c’est de la faute de l’équipe pédagogique (aïe Jean-Michel va devoir ré-intervenir !) qui m’a lié à Julie Chaumard par cadeau du livre et le hasard a fait d’elle une de mes évaluatrices. On a abordé la notion d’empathie sur le MOOC : ça existe et dans la notation aussi. Mais si sa note est gentille aussi, ses commentaires précis appuyaient où ça peut faire mal et c’est là le plus utile.

Pour votre livret, comment j’ai vu cette évaluation ?

D’abord je suis heureux pour vous de voir que vos autres notes sont au niveau de votre notation finale. J’en suis heureux mais pas rassuré car je viens de découvrir qu’un ingénieur de formation peut écrire “une des méthode de conception”, “vers les album,”, “Les collection principales “, “Compétence développées” et autres dans un rendu de MOOC sur FUN sans qu’aucun évaluateur ne se pose la question d’un travail si ce n’est vite fait, du moins pas relu.

Je sais : aujourd’hui l’orthographe est un détail pourtant ma correction est dans le sens du MOOC : L’idée, c’était de vous donner des clés pour vous améliorer (c’est peut-être là que j’ai été trop formateur).

Vous dire “it’s a great job” ça servait à quoi et surtout à qui ? (j’ai parlé du commentaire “très bien” sur mon livret et je garderais pour moi ce que j’ai pensé).

Votre livret comporte des fautes : faites-y attention, à plus forte raison dans un contexte de formation. Cela devrait être une des leçons de ce MOOC si vous envisagez une continuité. Ma note et mon commentaire disait ça, entre autres.

Après ce sont mes réflexes de correcteurs qui reprennent le dessus, je trouve des fautes donc je suis plus exigeant sur le contenu. il faut bien équilibrer.

Je n’y trouve pas la structure du MOOC, (dans laquelle certaines activités découlaient les unes des autres, vous les avez pourtant numérotés dans l’ordre du MOOC) et pas une autre non plus (voir photo ci-dessous, la référence que vous donnez sur la S1.2 et votre table des matières un peu différente).

Du coup, je doute encore plus à ces constats. Quand enfin je ne trouve rien d’autre que ce qui est demandé (sauf le référentiel et des images pour le moins pas libres de droits sans références, c’était 30 pts sur la note ça) et deux fois “Je” alors que la personnalité comptait, je ne vois pas comment je pourrais mettre 95 points ?

Et surtout, dans le contexte du MOOC, comment ne pas vous alerter sur ce qui pourrait vous aider à avancer ?

Rester sur un “très bien” ou un “great job” serait plutôt frustrant et le MOOC ArchInfo a été tout sauf ça. Avoir des indicateurs de progression, ça me paraît plus intéressant. C’est ce que ce MOOC m’a aussi apporté.

En tout cas, merci d’avoir apporté votre point de vue ici et sans rancune j’espère 😉

« Tout l’enjeu dans un MOOC est de se servir du nombre pour arriver à la notation la plus pertinente »

Je reste très sceptique :

La méthode utilisée dans ce mooc, est (si j’ai bien compris) de redistribuer aléatoirement toutes les évaluations en paquets de 4, de les trier par ordre croissant et de ne retenir que la 3ème note(la note médiane supérieure).

Peut ont rééellement parler ici de nombre ?

Une dizaine de livrets (sur une soixantaine d’évaluateurs?) a été revue par l’équipe pédagogique . Est ce efficace ?

Personellement je pense qu’une note ne veut rien dire, par contre le commentaire est important. Et si je les reprends:

orthographe un peu limite , structure basique , peu de personnalité

Un livret extrêmement agréable à lire du début à la fin, fluide et complet

De loin le meilleur livret consulté.

(je me revois devant mes évaluations : l’angoisse de la page vide !!!)

Je me pose la question: qu’attend t on d’ un architecte de l’information? une réflexion bien écrite sur son projet ou des livrables réalisables?

Sur le forum quelques heures avant la fin des évaluations 2 posts demandant des explications sur la correction donnée par l’équipe pédagagique d’une activité sont restées sans réponse… est-il nécessaire de bien cerner le sujet pour évaluer ?

Sinon encore bravo pour la qualité des cours et des interventions. Le sujet est passionnant.

“est-il nécessaire de bien cerner le sujet pour évaluer ?”

Ah, c’est souvent le débat sur les MOOC. La notion de pair et son total libre arbitre face à l’idée de pairs accompagnés pour évaluer. Vous aurez compris que je suis plutôt partisan du second cas. Mathieu Cisel, sur le premier MOOCAZ, dans son billet au sujet de l’évaluation par les pairs, disait :

“Vu que les participants ne sont pas des examinateurs professionnels, si vraiment vous êtes attachés à la précision de la notation, vous pouvez aussi mettre en place des guides de formation à l’évaluation, pour chaque devoir. ”

Lire au complet ici : http://blog.educpros.fr/matthieu-cisel/2014/08/18/mooc-et-evaluation-par-les-pairs-lepineuse-question-du-procede-de-notation/

Autre vue sur le même sujet (sur MOOC Expérience) :

“L’évaluation par les pairs n’est efficace uniquement parce qu’elle est multiple. Parce que c’est un pair, et non un enseignant reconnu qui corrige, une évaluation seule n’a aucun sens. Par exemple, sur notre page de présentation, plusieurs personnes ont dit que (justement !) le processus d’évaluation par les pairs n’était pas bien expliqué. Il est désormais évident que cette critique est constructive car elle est partagée par plusieurs personnes ; mais seule, est-ce que nous l’aurions réellement intégrée ? Donc, l’idéal serait d’établir un système de répartition des devoirs afin d’obtenir un volume d’évaluations suffisants par devoir afin de garantir une forme de fiabilité dans les évaluations”

https://moocexperienced.wordpress.com/2014/08/20/evaluation-par-les-pairs/

Je souhaite juste préciser mon post précédent:

“qu’attend t on d’ un architecte de l’information? une réflexion bien écrite sur son projet ou des livrables réalisables?”

je reformule mieux ma pensée :

“qu’attend t on d’ un architecte de l’information? des livrables bien conçus après une (longue) réflexion s’appuyant sur ses compétences.”

Et c’est une appréciation argumentée sur cette réflexion qui me paraîssait intéressante dans l’évaluation.

Quelques remarques pour faire suite…

Personnellement je suis déçue et très surprise que votre proposition de grille sur le forum n ait pas suscite plus d’échanges.

Ceux qui n’ont pas joué le jeu de l’évaluation motivée devraient être pénalisés : j’ai eu une note de 78 avec a côté : RAS..!!!

Je trouve de plus que l évaluation de la collaboration n’est pas équitable. Avoir une bonne note parce-que les livrets relus sont bons est problématique car rien ne dit que c’est notre aide qui a permis d’améliorer le livret..et inversement!

Merci de vos échanges ici, c’est une belle preuve de l’intérêt qu’à suscité le MOOC ArchInfo et donc encore merci à l’équipe pédagogique de nous avoir apporté tout cela.

Vos commentaires mettent aussi le doigt sur la question difficile de l’évaluation sur les MOOC (A ce que j’en ai vécu, ce n’est pas propre au MOOC ArchInfo).

La note est un système simple mais toujours discutable, la preuve ici : évaluation par des pairs ressentis comme “amateurs”, note non ou pas assez motivée, etc.

L’engagement des apprenants sur une analyse fine des rendus,, des activités, me parait devoir être plus poussée, mais là ce n’est pas simple. Comment motiver pour cela ?

C’est pourtant de cette façon que l’on peut obtenir et proposer de vraies marges de progression sur des MOOC.

Je découvre des liens, sur des pages signées de JM Salaun, qui envoient vers ici.

https://archinfo01.hypotheses.org/2016

http://archinfo01.hypotheses.org/1669

d’Abord merci, c’est beaucoup d’honneur que de prendre en compte mon petit point de vue d’apprenant.

Puis une réponse rapide puisqu’ils sont relativement critiques sur mon point de vue sur l’évaluation par les pairs, voire infantilisants, ce qui est une défense bizarre face à ce qui parait visiblement être considéré comme une agression. Ce n’était pas mon but, je cherchais juste à démonter la mécanique qui amenait à ces évaluations.

Le texte dit “Nous sommes tous profondément marqués par l’expérience, plus ou moins traumatisante, des notes reçues à l’école. Cet ancrage est très sensible chez les participants aux MOOCs impatients de recevoir des évaluations chiffrées” ajoutant que l’on pouvait ” vivre difficilement” ces évaluations.

Quel point de vue sur les inscrits aux MOOCs ! Donc j’ai visiblement mal vécu ce système de notation (Merci pour la psychanalyse, M. Salaun 😉 ) et, ça tombe bien, j’ai construit mes apprentissages autour d’autres systèmes, les MOOCs par exemple et particulièrement les MOOCs basés sur des activités avec des critères définis au préalable, maîtrisés par les évaluateurs et permettant donc d’évaluer le niveau de nos apprentissages pour engager une remédiation au besoin.

Ce qui est drôle c’est que, passé ce constat, ce Mooc demandait en fait de mettre … des notes ?!

L’important dans tout ça, c’est donc la conclusion, sous forme d’objectif pour le futur de ce MOOC, d’un des billets de JM Salaun :

“être plus clairs et précis sur les critères d’évaluation pour qu’ils conduisent à une amélioration des performances sur les compétences à acquérir”.

C’était pile le sens de mon analyse.